Yeni bir araştırmaya göre yapay zeka şirketlerinin büyük çoğunluğu, teknolojinin getirdiği felaket risklerini yönetmekte başarısız.

fazla oku

Bu bölüm, konuyla ilgili referans noktalarını içerir. (Related Nodes field)

Kâr amacı gütmeyen Future of Life Institute'teki yapay zeka güvenliği uzmanlarının değerlendirmesi, önde gelen 8 yapay zeka şirketinin "bu kadar güçlü sistemlerin gerektirdiği somut güvenlik önlemlerinden, bağımsız denetimden ve güvenilir uzun vadeli risk yönetimi stratejilerinden yoksun olduğunu" ortaya koydu.

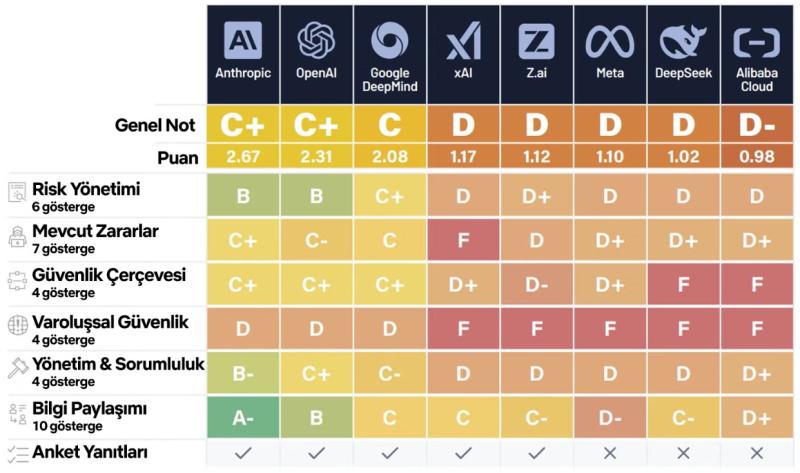

Yapay Zeka Güvenlik Endeksi'nde en iyi puanları ABD şirketleri alırken, Anthropic, ChatGPT'nin yaratıcısı OpenAI ve Google DeepMind'ı geride bıraktı. Çin şirketleriyse genel olarak en düşük notları alırken, Alibaba Cloud, DeepSeek'in hemen arkasında yer aldı.

Varoluşsal risk değerlendirmesinde hiçbir şirket D'nin üzerinde not almazken, Alibaba Cloud, DeepSeek, Meta, xAI ve Z.ai, F notu aldı.

Araştırmada, "Varoluşsal güvenlik, sektörün temel yapısal başarısızlığı olmaya devam ediyor ve hızlanan yapay genel zeka/süper zeka hedefleriyle güvenilir kontrol planlarının yokluğu arasındaki giderek genişleyen uçurum her gün daha endişe verici hale geliyor" dendi.

Şirketler yapay genel zeka ve süper zeka hedeflerini hızlandırırken, hiçbiri felaket niteliğindeki kötüye kullanımı veya kontrol kaybını önlemek için güvenilir bir plan ortaya koyamıyor.

Raporun yazarları, yapay zeka şirketlerinin kendi güvenlik değerlendirmelerinde daha şeffaf olmaları ve yapay zeka psikozu gibi daha acil zararlardan kullanıcıları korumak için daha fazla çaba göstermeleri çağrısında bulundu.

UC Berkeley'den bilgisayar bilimleri profesörü Stuart Russell, "Yapay zeka CEO'ları insanüstü yapay zekanın nasıl inşa edileceğini bildiklerini öne sürüyor ancak hiçbiri kontrolü kaybetmemizi nasıl önleyeceklerini gösteremiyor. Bu gelişmeden sonra insanlığın hayatta kalması artık bizim elimizde değil" dedi.

Nükleer reaktör gereksinimlerine uygun olarak, yıllık kontrol kaybı riskini yüz milyonda bire indirebileceklerine dair kanıt arıyorum. Bunun yerine, riskin onda bir, beşte bir, hatta üçte bir olabileceğini kabul ediyorlar ve bu sayıları ne haklı çıkarabiliyorlar ne de iyileştirebiliyorlar.

OpenAI temsilcisi, şirketin "sistemlere güçlü güvenlik önlemleri eklemek ve modelleri titizlikle test etmek" için bağımsız uzmanlarla çalıştığını belirtti.

Google sözcüsüyse şunları söyledi:

Sınır Güvenlik Çerçevemiz, güçlü sınır yapay zeka modellerinden kaynaklanan ciddi riskleri ortaya çıkmadan önce belirlemek ve azaltmak için özel protokoller sunuyor.

Modellerimiz daha gelişmiş hale geldikçe, kabiliyetlerimizle aynı hızda güvenlik ve yönetim konusunda yenilik yapmaya devam ediyoruz.

Independent, yorum için Alibaba Cloud, Anthropic, DeepSeek, xAI ve Z.ai'yla iletişime geçti.

*İçerik orijinal haline bağlı kalınarak çevrilmiştir. Independent Türkçe'nin editöryal politikasını yansıtmayabilir.

Independent Türkçe için çeviren: Çağatay Koparal

© The Independent